Attenzione al nonsense coerente

Molti parlano oggi, 2023, di AI. Spesso a vanvera, senza conoscenze di base, e solo perché ci hanno smanettato un po’, e come gli indiani che vendettero l’isola di Manhattan agli olandesi per $24 dollari di paccottiglia, si fanno affascinare da perline e specchietti (per le allodole).

Le AI, quindi, non servono? Le AI non mantengono le promesse di un mondo dove ci potremo finalmente liberare del lavoro (che è poi una punizione biblica: ” Con il sudore del tuo volto mangerai il pane; finché tornerai alla terra”)?

Le AI possono eliminare il lavoro, con tutte le conseguenze positive in termini di allargare il benessere, come hanno fatto la scienza, la tecnica e l’organizzazione negli ultimi 300 anni.

Ma siamo già a quel punto? Non proprio. Perché se parliamo di sistemi esperti, che – a migliaia – sono installati nelle grandi organizzazioni da decenni, sicuramente funzionano e sono molto produttivi, anche se la maggior parte della gente non li vede all’opera, ma ne subisce gli effetti, come quando chiedete un mutuo, un prestito o una carta di credito.

Ma aiutano anche nella determinazione di guasti di apparati complessi, come un aereo o un locomotore, e sono anche a bordo degli aerei per pilotarli, e anche nella vostra automobile.

Quindi, un automa, che sia il robot che salda le lamiere di una BMW o che sia un software che analizza il vostro merito creditizio per darvi un prestito, sono utili e indispensabili, a meno che uno non sia un imprenditore marginale che s’illude di poter continuare un’attività pagando poco o niente degli schiavi umani. Cosa purtroppo non infrequente.

Allora cos’è tutta quest’enfasi, questa frenesia sulle nuove AI?

Effettivamente c’è una novità: le AI generative, cioè applicazioni, che sono state riempite di miliardi di dati – miliardi di dati che oggi sono disponibili, perché quasi tutto lo scibile umano è stato digitalizzato, ma non tutto – e che permettono all’applicazione di fare delle cose molto sofisticate, che meravigliano per la loro capacità di imitare quello che farebbe una persona, che, alla fine della fiera, fa un lavoro meccanico che può essere imitato da una macchina.

Il problema dell”entusiasmo eccessivo è che chi fa le domande o pone dei compiti ad una AI generativa, è una persona limitata, che fa domande banali.

Provate a fargli delle domande, neppure troppo complesse, e non sarà capace di rispondere, neppure come farebbe Google alla stessa domanda, cioè con una lista di cose, che spesso non c’entrano, o vengono fuori nei primi posti perché qualcuno ha pagato.

Ho fatto una domanda banale per qualsiasi essere umano, che dovrebbe rispondere o “non lo so”, o dare la risposta giusta, o se ha dei dubbi, chiedermi un chiarimento.

La domanda posta era. “in quanti metri atterra un greyhound?”

Ho fatto la domanda a Google, che tira fuori la solita lista – poco utile – dove si deve fare un ulteriore ricerca “manuale” per cercare la notizia.

Alla stessa domanda, ChatGPT ammette di non sapere.

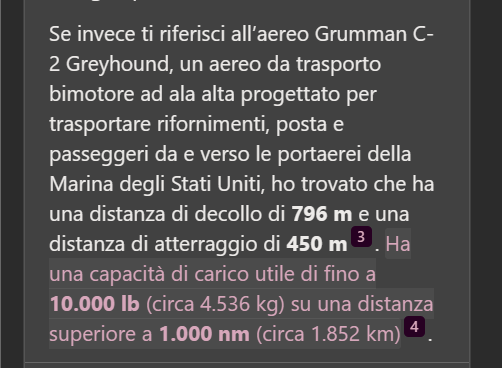

Mentre Bing AI fornisce due risposte perché non sa se la mia domanda riguarda un greyhound animale, cioè un levriero o un Grumman C-2 Greyhound, cioè un areo imbarcato sulle portaerei americane e francesi, che era la risposta che mi serviva.

Quindi Bing AI è più brava, ma non molto efficiente! Perché se chiedo “in quanti metri atterra un greyhound?”, qualsiasi persona che sappia cosa sia un greyhound cane o un greyhound aereo, darebbe subito la risposta relativa alla lunghezza della pista necessaria per far atterrare un Grumman C-2.

Qualche Pierino potrebbe dire che magari se avessi chiesto “in quanti metri atterra un Greyhound?” avrei fatto una domanda semanticamente e grammaticalmente corretta. Ma se parlo di “atterrare” è normale che una entità capisca che i levrieri non atterrano mentre gli aerei di solito si, e quando parliamo, non mettiamo le maiuscole.

Non è una demolizione di questi strumenti, ma un avvertimento che quello che si ha di fronte è un idiot savant, e non un savant e basta. E quindi, è meglio prendere le risposte cum grano salis, cioè aggiungendo quello che è ancora umano e solo umano: il discernimento. E quindi non fidarsi completamente delle risposte delle AI generative, come spiega anche il MIT perché questo tipo di AI possono generare un nonsense coerente cioè qualcosa che sembra razionale, ma che non lo è quando la si esamina con discernimento e conoscenza dell’argomento, e che può essere stato indotto da una persona che non conosce l’argomento e quindi induce la macchina a dare belle risposte ma che sono senza senso.