Non é magia. È tecnologia

Per i demolitori delle AI, che non hanno una idea precisa su come funzioni

Ma quindi, come funziona davvero un LLM?

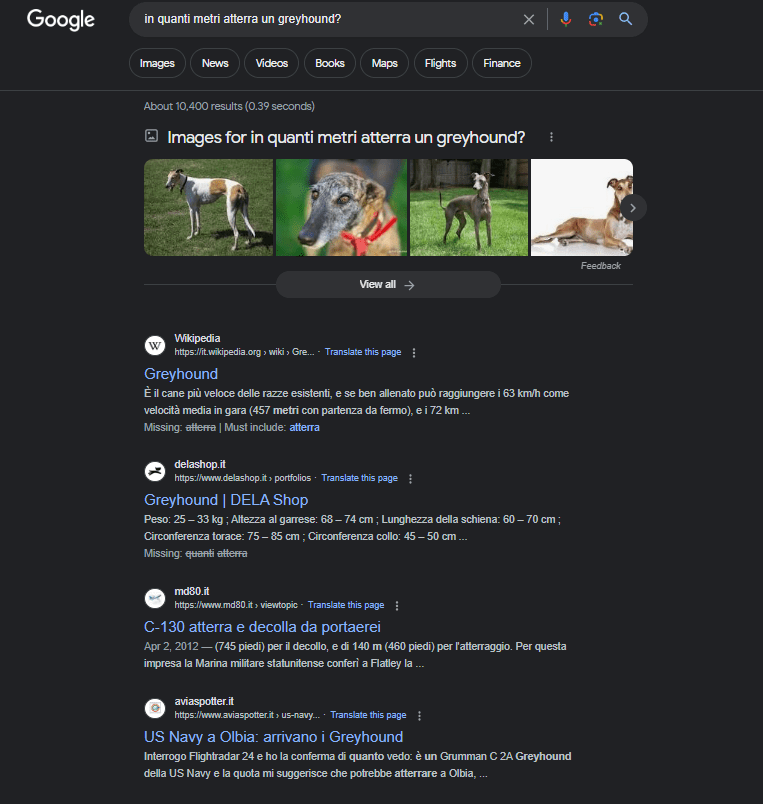

Partiamo da qui: un LLM non “pensa”, non capisce cosa dice, non ha intenzioni, obiettivi o modelli del mondo come li intendiamo noi. Ma allora perché sembra intelligente?

Perché è stato addestrato su miliardi di parole e ha imparato a prevedere la parola (o token) più probabile che segue in una sequenza di testo. Lo fa un passo alla volta, senza sapere dove sta andando. L’architettura si chiama autoregressiva: il modello guarda indietro (il testo già generato) per decidere cosa viene dopo.

Non costruisce concetti, non ragiona su significati: impara correlazioni statistiche. Se leggi e analizzi milioni di articoli, libri, tweet e manuali, inizi a “intuire” come scrivere cose che sembrano sensate. È questo che fa un LLM: imita il modo in cui gli umani parlano di un argomento, senza sapere cosa l’argomento sia.

Detto così sembra banale — e lo era — finché i modelli non sono diventati enormi. Quando hai abbastanza parametri e abbastanza dati, iniziano a succedere cose strane: riescono a fare logica, a pianificare, a risolvere problemi, anche senza che nessuno gli abbia spiegato come. È quello che molti chiamano “emergenza”, anche se spesso è solo effetto scala: più roba dentro, comportamenti più raffinati fuori.

Però non è magia: è statistica. Solo che a un certo punto la statistica diventa sorprendentemente potente.

Ma non c’è solo l’LLM nudo e crudo

I modelli moderni — come ChatGPT — non sono solo autoregressori isolati. Sono sistemi complessi che usano l’LLM come cervello linguistico, ma lo collegano a:

memorie (per ricordare conversazioni passate),

strumenti esterni (motori di ricerca, calcolatrici, database, API),

codice eseguibile (per generare ed eseguire comandi),

e meccanismi di feedback umano (es. RLHF, che premia risposte utili, sicure, pertinenti).

Quindi, anche se il modello di base “completa testo”, il sistema complessivo può pianificare, rispondere in modo mirato, verificare risultati, riscrivere e correggere. In certi casi, può anche rifiutarsi di rispondere se capisce (o simula di capire) che non è il caso.

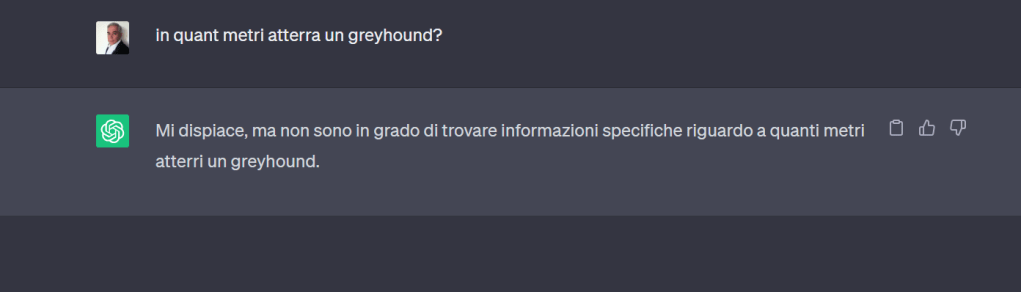

Non ha “intelligenza”, ma ha ottime maschere

Il LLM non ha una mappa simbolica del mondo, ma ha una rappresentazione implicita: sa che “il fuoco brucia” e che “Napoleone è morto” perché queste informazioni ricorrono nei testi. Le codifica in una forma compressa, dentro decine di miliardi di pesi.

Questo non è sapere, ma riflette ciò che ha letto. E spesso basta a dare l’illusione di intelligenza. È un effetto di superficie: sembra intelligente perché parla come se lo fosse.

Quindi attenzione

Quando usi un LLM, non stai parlando con una mente, stai interrogando un sistema probabilistico di completamento linguistico molto avanzato, talvolta arricchito con strumenti esterni.

Funziona bene? Spesso sì. Ma il criterio che guida la generazione è plausibilità linguistica, non verità, non logica, non intenzione.

È un simulatore di linguaggio. E se gli chiedi cose che suonano plausibili ma sono sbagliate, potrebbe risponderti con perfetta sicurezza… una sciocchezza.

Non è un dio, non è un mostro, non è un filosofo, e non è tuo cugino che sa tutto: è una macchina che completa frasi. Ma lo fa così bene, che ci inganna tutti — compresi quelli che dovrebbero saperne di più.

Capirlo non serve per denigrare. Serve per usarlo bene. Perché se deleghi funzioni cognitive a un sistema che cognitivo non è, la responsabilità delle decisioni — spoiler — resta tua.